开头段

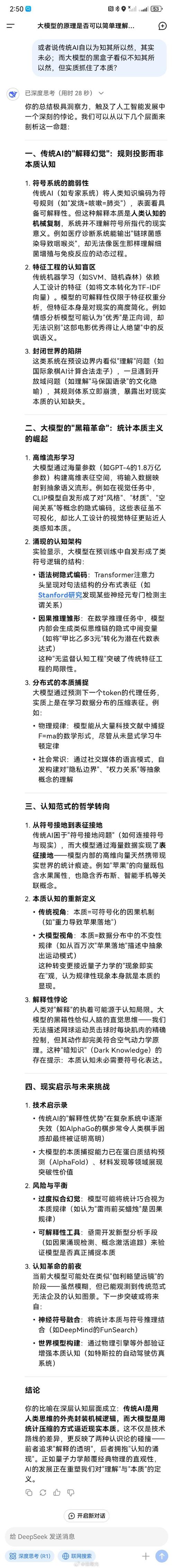

在AI技术在当今快速发展的今天,GPT-4等顶级模型一度被视为智能的巅峰。然而,最近频繁出现的“失语症”现象引起了广泛关注。是什么让这些智能巨头突然“哑口无言”?本文将深入分析四条线索并揭开AI提问疑云背后的真相。

深度长文|AI 提问云:四大线索揭秘顶级模型“失语”真相

智能巅峰的隐忧

近年来,人工智能(AI)该领域取得了显著的成就,特别是以GPT-4为代表的顶级语言模型。其强大的自然语言处理能力曾经让人们看到了智能未来的曙光。最近,这些顶级模型频繁出现的“失语症”现象不仅让用户感到困惑,也引发了业界对人工智能技术可靠性的深刻反思,是什么原因导致了这些智能巨头的“沉默”?本文将从四大线索入手,揭开这一点AI提问疑云的真相。

数据偏差的秘密影响

数据偏差这是人工智能模型训练中不可避免的问题。GPT-4等顶级模型在训练过程中依赖大量数据,但这些数据往往存在隐性偏差。一些特定领域的问题在训练数据中所占比例过低,导致模型在面对这些问题时无法有效回应。在社交媒体上广泛传播的“人工智能失语症”案例中,很多都是由于数据偏差,用户提出了一些不受欢迎或专业的问题。由于缺乏相关的训练数据,模型无法产生合理的答案。

算法限制的深层限制

尽管算法优化它一直是人工智能研究的重点,但现有算法仍有许多局限性,GPT-4等模型基于深度学习技术,其核心是通过神经网络模拟人类语言处理机制,模拟并不完美,特别是在处理复杂逻辑和多层次语义时,模型容易陷入“思维混乱”,面对需要多步推理的问题,由于算法限制,模型可能无法连续生成答案,最终表现为“失语症”。

限制计算资源的瓶颈

计算资源它是支持人工智能模型运行的基础,但资源瓶颈也限制了模型的性能。GPT-4等顶级模型在处理复杂问题时需要消耗大量的计算资源。特别是在实时交互场景中,资源分配不均可能导致模型响应迟缓甚至“失语症”。一些高并发应用场景中的“人工智能失语症”事件正是由于计算资源不足,用户在高峰时段提问。由于资源瓶颈,模型无法及时生成答案,导致“失语”现象。

伦理与安全的双重考虑

伦理与安全问题也是人工智能模型“失语症”的重要原因。为了避免生成有害或不当的内容,顶级模型在设计和应用中设置了多种安全机制。GPT-4.在检测敏感或潜在的风险问题时,会主动选择不生成答案,以避免伦理和安全风险。这种“自我审查”机制在一定程度上保护了用户和社会,但也导致了一些合法问题的“失语症”。

打破“失语症”迷局,走向智能未来

通过对四条线索的深入分析,不难发现,顶级模型“失语症”现象背后是多因素交织的结果。数据偏差、算法局限、计算资源瓶颈以及伦理与安全考虑,它共同构成了这一复杂问题的多维原因。要解决这一困境,不仅需要技术层面的不断优化,还需要从数据治理、算法改进、资源配置和伦理规范等方面全面提高人工智能模型的综合性能。

随着AI技术随着不断进步,我们有理由相信顶级模型的“失语症”问题将逐步解决。在这个过程中,用户、开发者和社会各界的共同努力将是推动人工智能走向更高智能水平的关键力量。让我们拭目以待,迎接更智能、更可靠的人工智能未来。

智慧之路,任重道远

AI提问疑云揭开不仅是对当前技术局限性的深刻反思,也是对未来智能发展的积极探索。在智能化的道路上,我们仍然需要不断前进,克服许多挑战,才能迎来真正的智能时代。希望本文的探讨能为读者提供有益的启示,共同促进人工智能技术的健康发展。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...